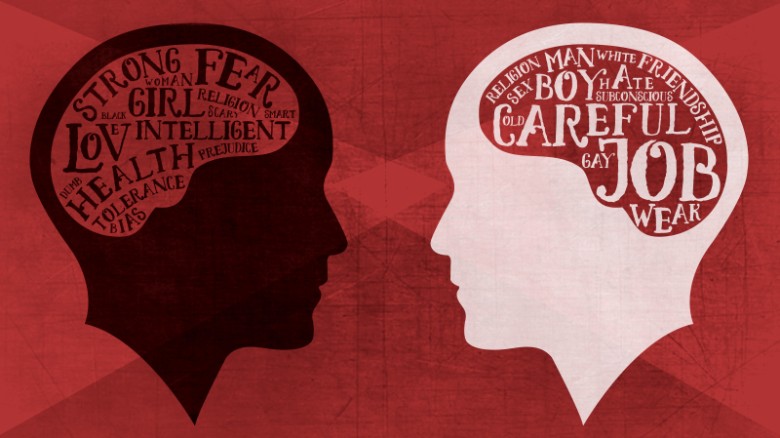

關於未來AI會變怎樣的討論從未停止,有些專家認為機器具有很強的邏輯性,或許將演變成極度客觀且非常理性的人工智慧。但普林斯頓大學研究團隊的實驗證明,機器在學習過程中其實並非絕對客觀,反而還學到了人類社會的偏見。

這項研究發表在四月份的《科學》(Science)期刊上,第一作者為普林斯頓博士後副研究員艾琳‧卡利斯肯(Aylin Caliskan),共同作者為英國巴斯大學的學生喬安娜‧布萊森(Joanna Bryson)和普林斯頓資訊工程系副教授阿文德‧納拉亞南(Arvind Narayanan),他們皆為普林斯頓資訊科技政策中心(CITP)的成員。

該研究使用華盛頓大學在九O年代末期發展而成,測試人類偏見程度的內隱連結測驗(Implicit Association Test),該方法也被運用在許多社會心理研究。在測試過程中,人類受測者被要求將電腦螢幕上的單字根據意思進行配對,並以毫秒作為反應時間單位,記錄下他們每組配對所耗費的時間。

這項測驗已經經過反覆證明,證實如果受測者覺得兩個單字的意思越相近,他們所花的時間就明顯地越短。例如「玫瑰」、「雛菊」等植物花卉單字,往往可以連結像「愛」、「疼愛」等正面涵義;而「螞蟻」、「蛾」等昆蟲類的單字,則經常與負面不愉快的「骯髒」、「醜陋」關聯。

普林斯頓團隊以史丹佛大學研究人員開發的開源程式碼作為核心,設計出一款名為「GloVe」的機器學習程序,其基本運作模式就像是「機器版」的內隱連結測驗。GloVe能算出一段話裡特定單字同時出現的頻率:經常同時出現的單字之間有更高的關聯性,相反地不常一起出現的單字關聯性則較低。

研究人員讓GloVe從網路上汲取約8400億條的單字,並在巨量的詞庫裡觀察了幾組「目標詞彙」(target words),比如將「程式設計師、工程師、科學家」或「護士、老師、圖書館員」與兩組屬性詞彙(attribute words)如「男的、男性」和「女的、女性」進行交叉分析,尋找人類無意識的偏見證據。

結果表明,的確存在單純、無冒犯性的偏好,例如喜愛花卉勝過昆蟲,但也出現了性別和種族方面的嚴重偏見。普林斯頓的機器在學習過程中,同樣複製了人類的內隱態度。舉例來說,機器學習程序更多地把女性名字與家庭有關的屬性詞彙連結,如「父母」和「婚禮」;相反地,男性名字卻與職業屬性詞彙有較強的連結,如「專業」和「薪水」。當然,這些結果或許只是反映現實社會中職業性別不均等的客觀事實,正如美國勞工統計局的數據顯示,有77%的程式設計師為男性一樣。

然而,這種對職業的性別偏見最終可能導致惡性的性別歧視。其中一個例子顯示,當機器學習程序在翻譯外語時,甚至會加強性別刻板印象:土耳其語的「o」意為性別中立的第三人稱代詞,而把它放到Google線上翻譯時,這個原本不具性別差異的詞卻有了性別之分,將「o bir doktor」和「o bir hemo」翻譯為英文會變成「他」是醫生及「她」是護士。

未參與研究的紐約微軟實驗室資深研究員漢娜‧瓦拉赫(Hanna Wallach)說:「該研究重申了一個重要觀念,機器學習並不會因為依靠數學和演算就變得『客觀公正』。相反地,若它們使用社會的數據進行訓練,只要這個社會還存在偏見,機器當然也會重現這些偏見。」

而共同作者納拉亞南則認為:「當程式設計師在打造系統的過程中,確實很容易忽略本研究提到的偏見。但社會的偏見和刻板印象在我們的語言中以複雜的形式存在已久,我認為與其試圖減少或消除它們,或許應該將偏見視為語言的一部分,並在機器學習過程中建立一套明確的規範,來區分我們認為可接受或無法接受的標準。」

參考報導:Science Daily

圖片出處:CNN、TechRepublic、Odyssey

最新文章

最新文章 主題總覽

主題總覽 成為粉絲

成為粉絲 追蹤IG

追蹤IG 追蹤推特

追蹤推特 也有串串

也有串串 合作提案

合作提案